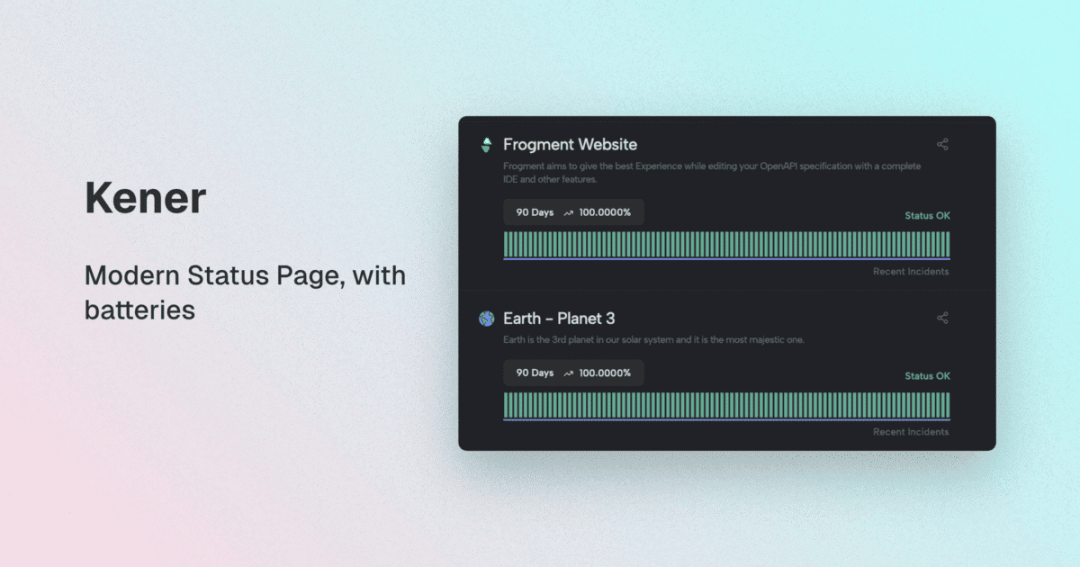

NAS 轻松部署 Serge:本地也能运行大语言模型

Serge:

一个基于 llama.cpp 构建的聊天界面,用于运行 LLM 模型。无需 API 密钥,完全自托管。

安装

Docker Compose

services:

serge:

image: ghcr.io/serge-chat/serge:latest

container_name: serge

restart: unless-stopped

ports:

- 8008:8008

volumes:

- /vol1/1000/docker/serge/weights:/usr/src/app/weights

- /vol1/1000/docker/serge/datadb:/data/db参数说明(更多参数设置建议去看文档)

/usr/src/app/weights:模型相关的权重文件

/data/db:数据存储

使用

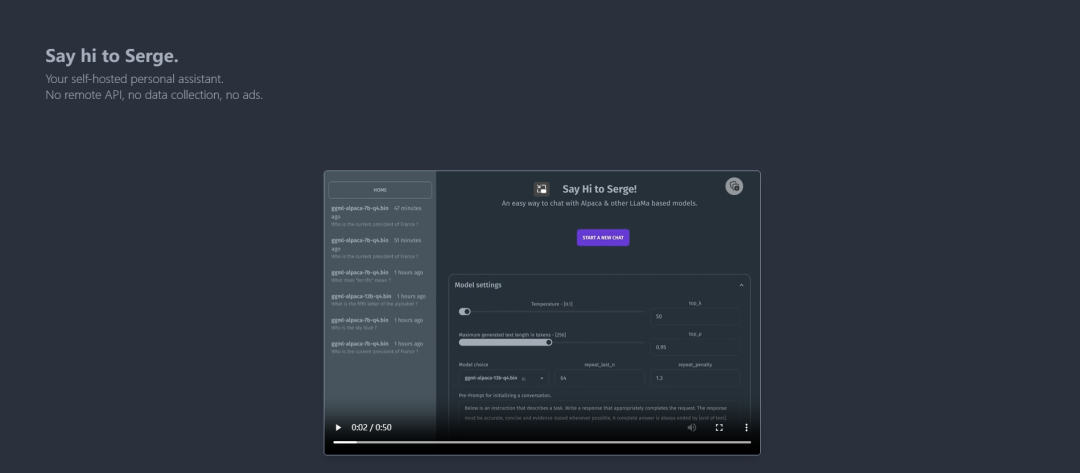

初次启动会自动下载文件,需要等待下载完成,可以去日志查看情况

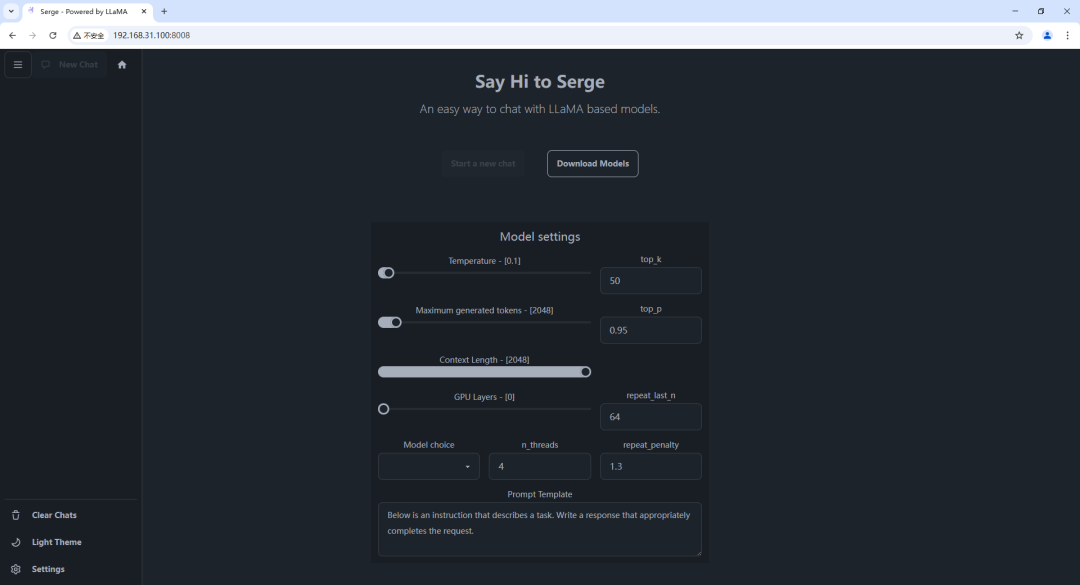

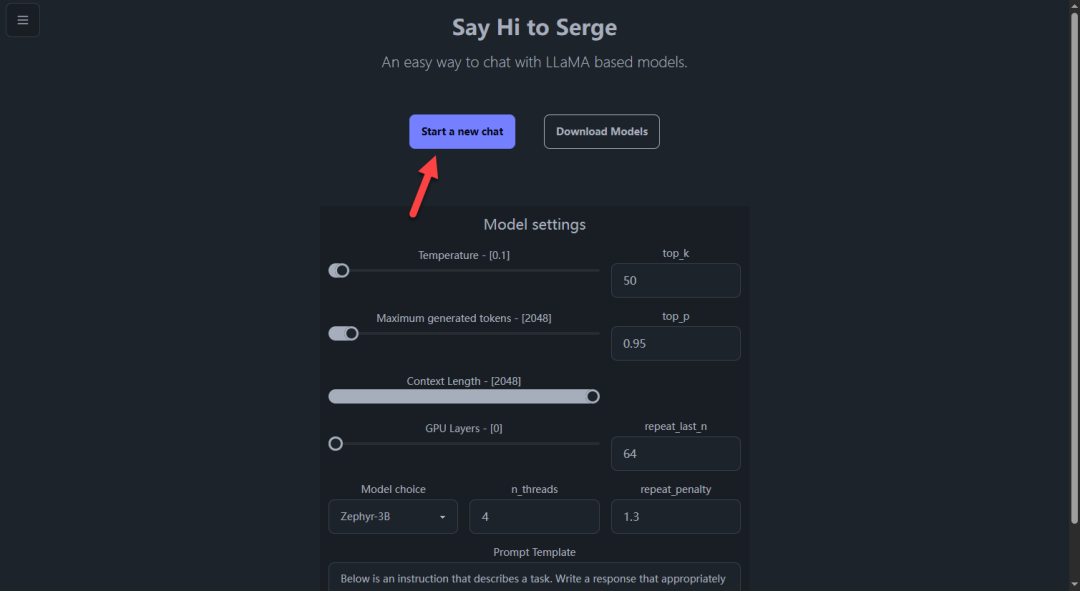

浏览器中输入 http://NAS的IP:8008 就能看到界面

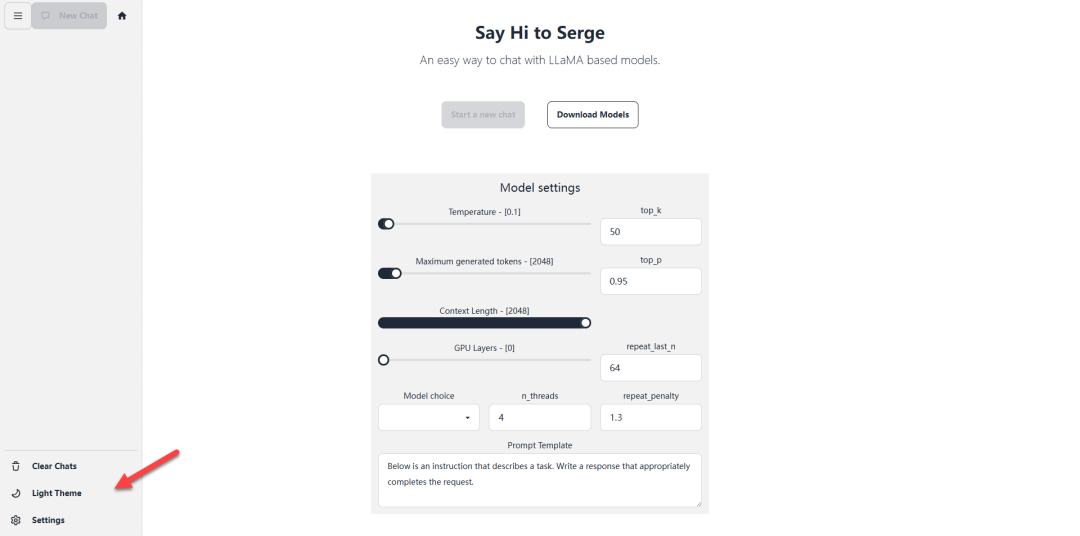

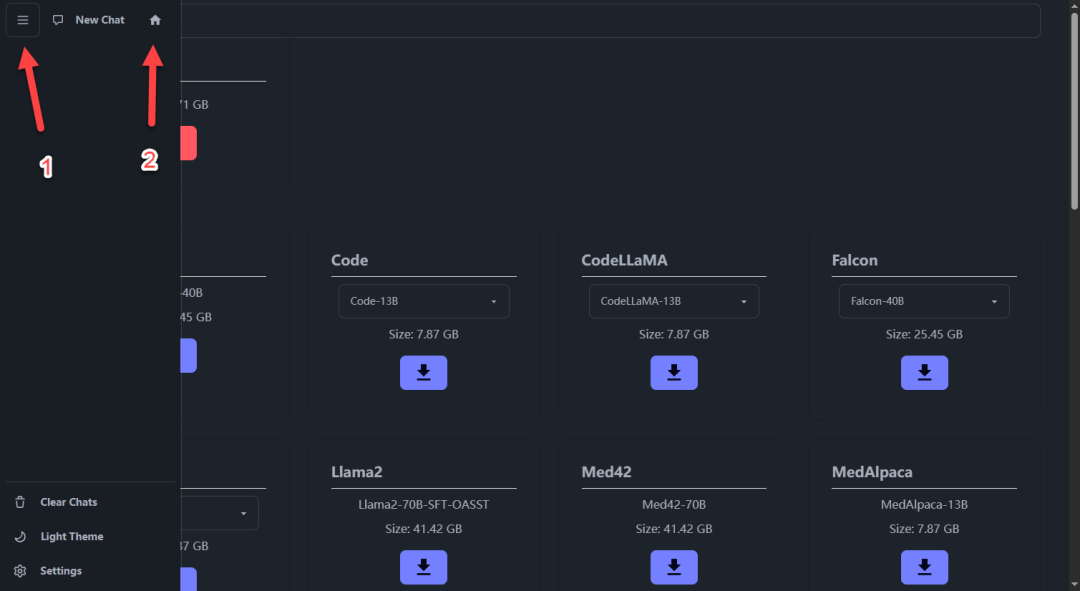

可以切换浅色主题

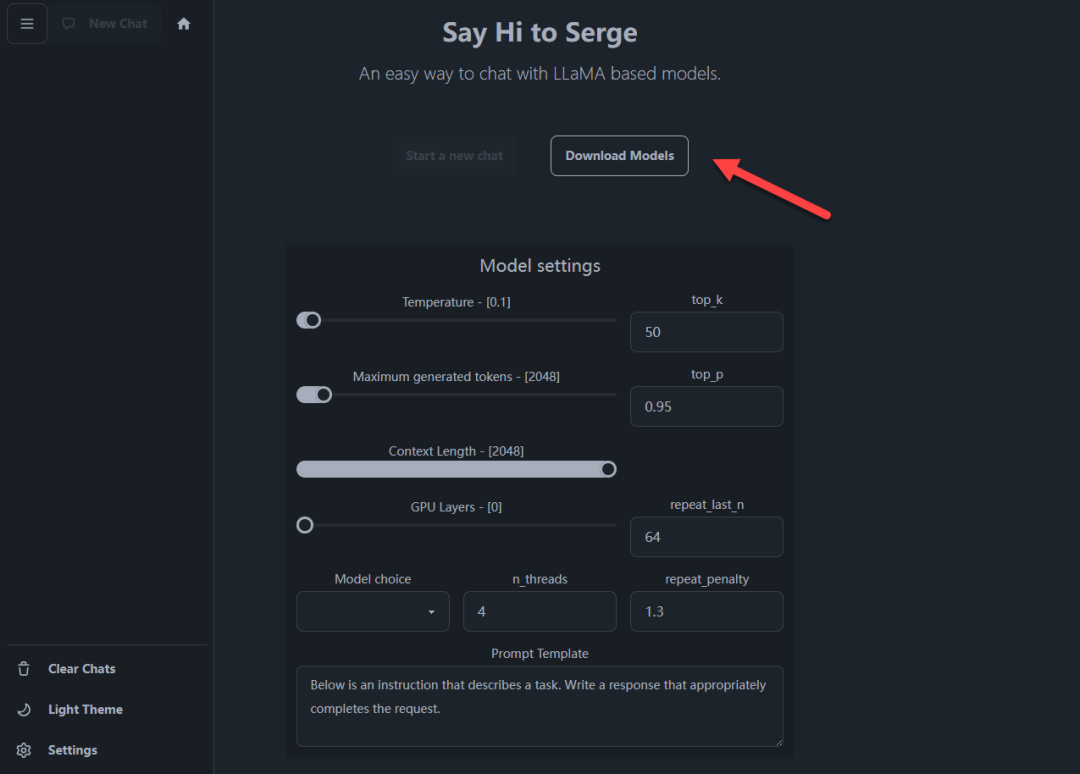

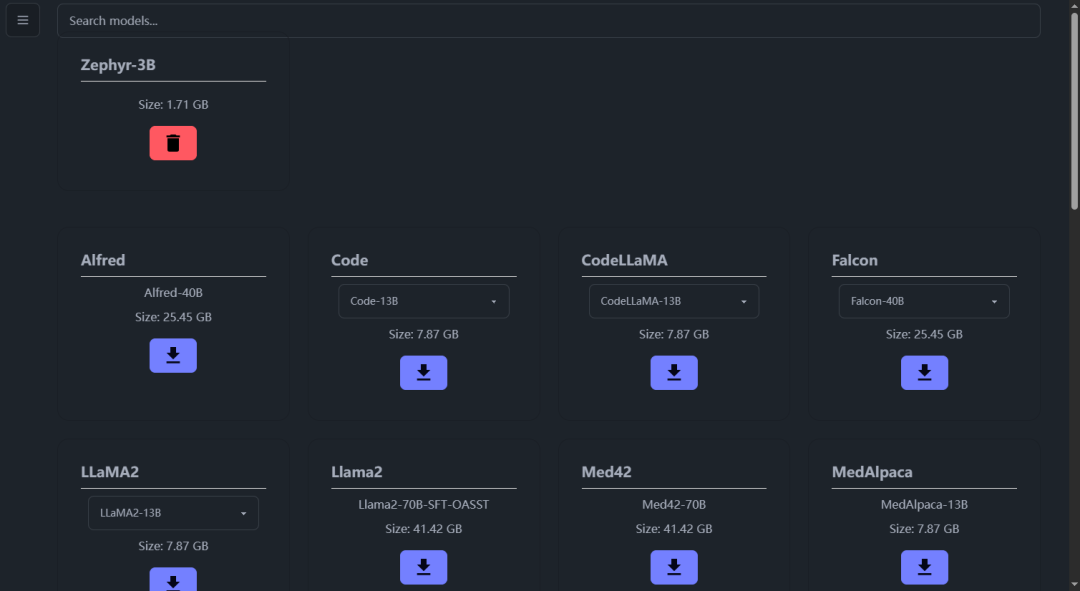

首先需要下载模型

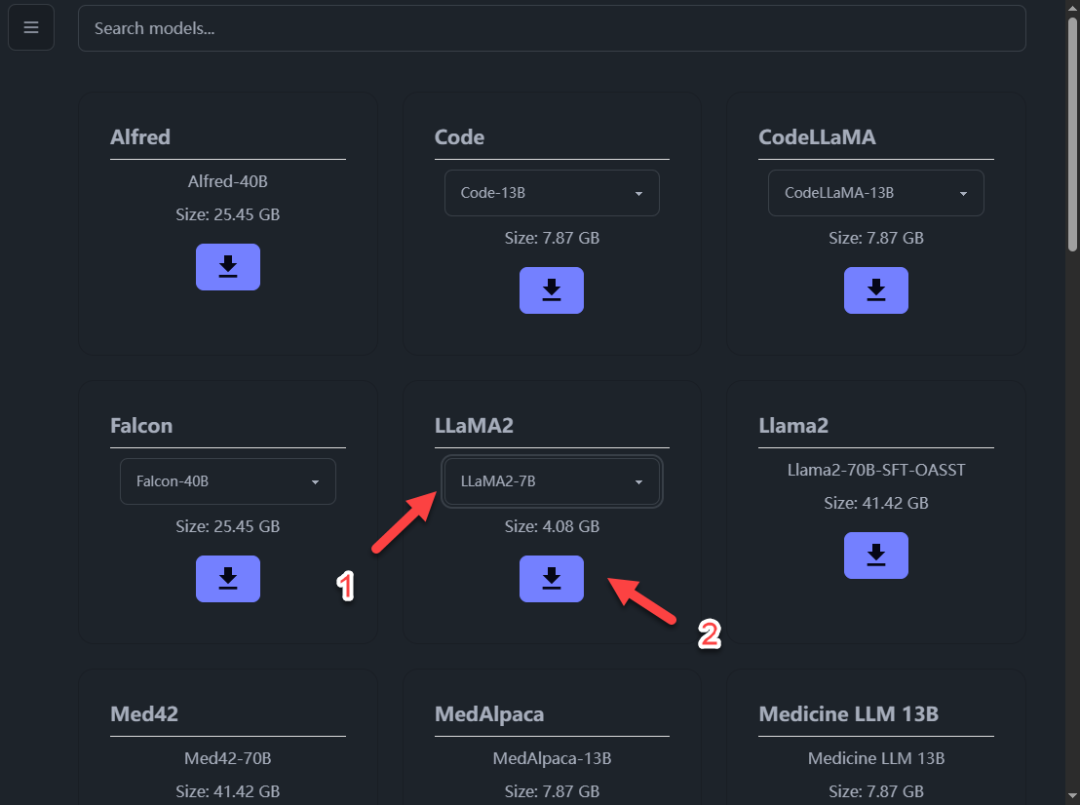

提供模型数量也不少

每个模型都有标注大小,下面是对应所需内存情况:

7B 需要大约 4.5GB 的可用 RAM

13B 需要大约 12GB 的可用 RAM

30B 需要大约 20GB 的可用 RAM

根据自己配置情况下载模型(不建议下载大于 13B 的,回复速度太慢了,影响体验)

TIP:

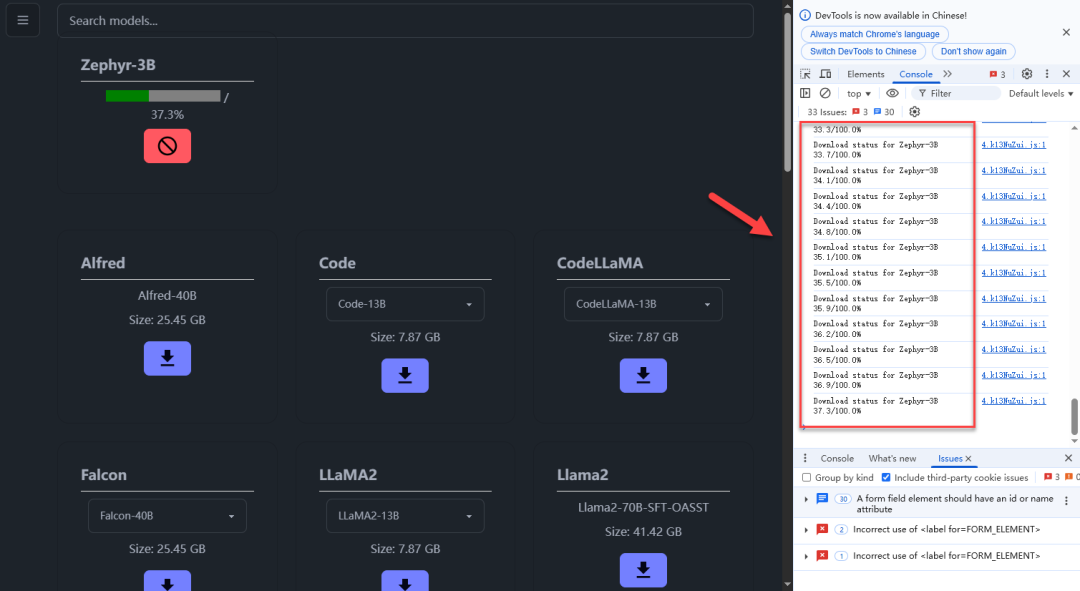

点击了下载按钮但没反应,大概率是网络问题

等待下载完成即可

这样就表示下载完成(不要点击,那个按钮是删除)

返回首页

这里可用选择模型和进行设置(不会设置,这里默认就行),点击开始聊天

回复都是没问题的

这里是虚拟机进行测试的,所以 CPU 看起来跑满了,内存占用比较少,毕竟是 1.5b 的小模型

总结

如果想作为生产力工具平时使用就不太建议了,不如直接调用 API 的方式;作为本地模型的话,提供下载的模型数量又不如 Ollama 多。不过个人部署体验玩玩还是不错的,只需要下载模型就可以直接使用了,非常方便已经包含框架和界面了。不知道是不是错觉,之前也部署过 Serge 当时好像下载还比较轻松,现在老是下到一般就断开了,而且必须要有良好网络条件。

综合推荐:⭐⭐⭐(可以尝试一下)

使用体验:⭐⭐⭐(简单快捷)

部署难易:⭐⭐(简单)

延伸阅读:

NAS 轻松部署 Serge:本地也能运行大语言模型

Serge:一个基于 llama.cpp 构建的聊天界面,用于运行 LLM 模型。无需 API 密钥,完全自托管。安装D...

14款免费NAS,操作系统及引导!黑群、黑威、Unraid开心版、TrueNAS、国产开源等,先码后看

前言618已至,各大品牌NAS卖的也是如火如荼,打新打折好不热闹。不过应该也有很多小伙伴还在观望吧,是什么让你迟疑一直没...